000 - 课程演示

001 - Python爬虫介绍

002 - Python爬虫课程介绍

100 - Anaconda创建环境

101 - PyCharm激活

102 - 使用PyCharm运行第一个Python程序

103 - 回顾爬虫流程

104 - 回顾HTML

105 - Get请求和Post请求的区别

106 - 状态码

200 - 使用Requests包发起请求

201 - 使用Requests获得网页源代码

202 - 使用Requests访问知乎

203 - Headers中的UserAgent

204 - 使用爬虫伪装成浏览器

205 - Get请求中的Param参数

206 - 爬取视频信息

207 - 下载图片信息

208 - 作业1爬取一个页面保存到本地的index中

209 - 作业2下载两个图片保存到本地jpg中

210 - 作业3爬取网站中所有的图片路径并且下载

211 - 作业3使用正则获取到图片路径

212 - 作业3爬取图片

213 - 作业3爬取图片带标题

214 - 总结Requests模块的API

215 - Response模块

216 - Json与Python的转换

217 - 设置代理爬虫

218 - 设置超时时间与代理

219 - 模拟Post请求

220 - Post中添加参数

221 - Post中添加文件

222 - Cookies会话

223 - 图解Cookies

224 - Cookies整体流程与偷换

225 - Requests模拟登录

226 - 查看登录之后的Cookies

227 - 对比携带Cookies登录与未携带

228 - 手动传入Cookies登录

229 - 爬虫注意Robots文件

230 - 模拟百度登录

231 - 模拟视频网址的登录

232 - 模拟Bilibili的登录

233 - 完成Bilibili的模拟登录

301 - 导入BS4

302 - BS4的使用

303 - BS4中find_all的使用

304 - Find_all中的Attr属性

305 - 获取该A标签下的Img标签中的Src

306 - Find_all方法的返回值

307 - 完成BS4中核心API讲解

308 - BS4中其他API的讲解

309 - Find_all中的text

310 - Find方法

311 - 完成BS4的讲解

401 - 爬取高考网系列图片

402 - 获取A标签与标题

403 - 创建系列文件夹

404 - 再次请求详情页面得到数据

405 - 多种方法找到Src

406 - 保存图片

407 - 图片的翻页

408 - 修改详情的Url

409 - 完成高考网系列图片的获取

410 - 前程无忧的数据爬取

411 - 解析网站源代码

412 - 找到第一页的所有的工作

413 - 保存公司名称与职位名称

414 - 获取一页的所有工作

415 - 如何翻页

416 - 完成翻页操作

417 - 将文件保存到txt中

418 - 将文件保存到csv中

419 - 完成前程无忧的数据爬取

420 - 不同职位的爬取

421 - 拓展获取区域码

422 - Python链接数据库

423 - 在表中插入数据

424 - 完成Python操作数据库与动态请求的获取

425 - Bilibili中的动态请求

426 - 爬Bilibili的图片

427 - 动态请求的返回值

428 - 爬取高清图片

429 - 每次获取的图片都不一样

430 - Python判断文件路径是否存在

431 - 完成Bilibili的爬取

432 - 设置Cookies再次爬取Bilibili

433 - Gearmk视频爬取

434 - 什么样的视频是我们暂时可以爬取的

435 - 找视频的地址

436 - 找到Script标签

437 - 拿到视频URL

438 - 爬取Gearmk一个视频

439 - 爬取Gearmk所有视频

440 - 爬取Gearmk一个系列的视频

441 - 获取一个系列的视频Id

442 - 获取动态请求

443 - 翻页的操作

444 - 完成Gearmk视频网站的所有视频爬取

445 - 巴乐兔房源的爬取

446 - 找要找的信息

447 - 发起请求获取页面

448 - 使用BS4定位到房源信息

449 - 保存房子基本信息

450 - 获得房子的类型

451 - 获得房子的朝向等信息

452 - 完成获得巴乐兔的数据

453 - 保存巴乐兔的数据

454 - 查看巴乐兔的数据

455 - 爬取巴乐兔多页的数据

456 - 爬取保存巴乐兔多页的数据

457 - 完成巴乐兔信息爬取

458 - 游民星空的壁纸爬取

459 - 游民星空的反爬虫机制

460 - 分析游民星空返回的Json

461 - 分析获取图片

462 - 完成游民星空的图片爬取

463 - 手动解析Url编码

464 - 分析一系列原画如何获取

465 - 回顾爬取游民星空的整个过程

466 - 书写爬取一系列图片的代码

467 - 完成游民星空的壁纸获取代码

468 - 完成爬虫的讲解

501 - QQ音乐的爬取

502 - 查看多首歌的URL的不同

503 - 爬取某歌单里的所有的歌

504 - 对比URL的不同寻找参数

505 - 找相应的参数信息

506 - 找到第一个参数的信息

507 - 找Vkey

508 - 找动态请求

509 - 找到并对比URL的不同

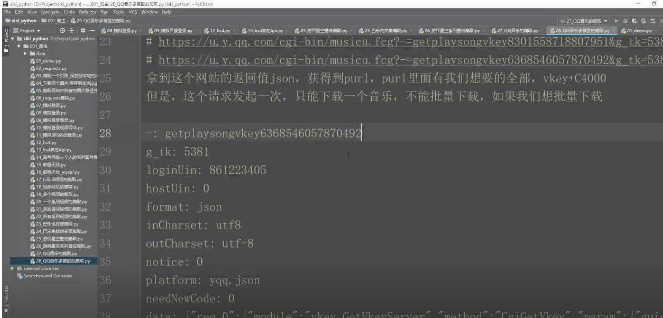

510 - 找Getplaysongvkey

511 - 下载JS文件找到Getplaysongvkey的代码

512 - 完成分析QQ音乐爬取的整个逻辑

513 - 代码爬取QQ音乐专辑

514 - 制作获得歌的URL

515 - 完成一个歌单中所有歌的爬取

516 - 拓展爬取某个歌手的歌曲

517 - 拓展获得到歌手的SongList

518 - 拓展爬取歌手的所有歌曲

519 - 拓展爬取所有歌手的所有歌曲

520 - 拓展完成爬取所有歌手的所有歌曲

521 - 拓展测试爬取所有歌手的所有歌曲

522 - 拓展测试翻页

523 - 拓展获取所有歌单的Dissid

524 - 拓展QQ音乐获得所有歌单的反爬虫

525 - 拓展获取QQ音乐上所有歌单的歌

526 - 评论大水军的分析

527 - 分析评论的动态请求

528 - 分析动态请求中的参数

529 - 发起请求拿到返回Json

530 - 加上Referer和UA继续爬取

531 - 完成水军的添加评论

532 - 给IKU制作一个水军

533 - 完成IKU一首歌曲的评论

534 - 获取所有IKU的歌曲

535 - IKU水军开启

536 - 查看那些评论失败的Json

537 - QQ音乐点赞大水军的制作

538 - 对比URL的不同

539 - 分析如何批量点赞

540 - 获得一首歌曲下的所有评论

541 - 获得一首歌曲下的所有评论Id

542 - Rootcommentid的获取分析

543 - 测试批量点赞

544 - 完成批量点赞

545 - 给一个歌手的所有歌曲评论点赞

546 - 完成QQ音乐水军的所有讲解

601 - 蛋壳公寓的爬取

602 - 页面的获取

603 - 获取房源ID

604 - 获取房源距离个站点的米数

605 - 获取面积等信息

606 - 获取房屋的朝向整合租

607 - 保存一页的数据到列表

608 - 将数据写入文件夹

609 - 找到保存文件的Bug

610 - 完成一页的爬取

611 - 完成蛋壳公寓的爬取

612 - 创建数据库

613 - 将数据保存到数据库

614 - 对数据库的一些补充知识

615 - 添加室友的信息

616 - 获得室友的信息

617 - 获得室友的性别

618 - 保存室友信息到本地

619 - 保存室友信息到数据库

620 - 保存室友信息到数据库的SQL语句

621 - 完成蛋壳公寓的爬取

701 - 同城约会信息爬取

702 - 查看是静态请求还是动态请求

703 - 发起请求拿到List

704 - 拿到用户的字段

705 - 拿到用户剩余的字段

706 - 完成用户字段的爬取

707 - 将数据保存到列表

708 - 解决爬取的异常

709 - 分析请求页面的参数意义

710 - 查看爬取的信息

711 - 查看多出来的数据

712 - 将数据保存到数据库去重

713 - 链接MySQL

714 - 完成一个城市的爬取

715 - 如何把没有头像的人剔除

716 - 爬取所有的女生信息

717 - 结束语

「Python爬虫从爪巴到爬」

关注公众号

防丢失不迷路

紧急通知!

由于运营商拦截,目前江苏部分地区打不开

新地址更换通知将在公众号发布

为防止大家找不到地址还请关注公众号第一时间获取

最新资源交流QQ群:935733529